Aloud: la nuova piattaforma di doppiaggio automatico che rivoluzionerà YouTube

Traduzione istantanea, imitazione della voce, modifica del labiale: queste sono alcune delle innovazioni di Aloud. Lo strumento porterà a una diffusione dei contenuti su scala globale, ma anche a una maggiore competizione tra youtuber. A rischio il settore dei doppiatori.

di Pietro Speroni di Fenizio, esperto in intelligenza artificiale e big data

Nei prossimi mesi YouTube introdurrà un sistema di doppiaggio in automatico dei suoi video. È stato già annunciato con un post nel blog di Google, e si chiamerà Aloud.

Il sistema, frutto dell’intelligenza artificiale, è composto di vari elementi. Prima di tutto l’audio viene trasformato in testo scritto. Questo testo viene poi tradotto (spesso cercando di mantenere la lunghezza delle parole quando possibile) e trasformato nuovamente in audio, sostituendolo all’originale.

Questa tecnologia è stata migliorata nel corso del tempo. Prima di tutto attraverso la comprensione dal tono della voce di chi parla. Poi tramite la capacità di sostituire il parlato di un attore in una lingua con un audio in un’altra lingua, ma sempre con la voce dello stesso attore. Invece di sentire il doppiatore, come siamo abituati, ascolteremo quindi l‘attore di turno parlare una lingua che (forse) nemmeno conosce. La tecnologia attuale è anche in grado di modificare il movimento delle labbra per adattarsi al nuovo audio. Infine, YouTube potrebbe proporre con il tempo due versioni del doppiaggio: una per adulti, e un’altra, edulcorata, adatta a un pubblico più giovane.

Nel video, un esempio di doppiaggio con l'AI applicato al film "Un sacco bello"

Per ora il controllo resta al creator, che deciderà quali traduzioni permettere e quali no. Ma trattandosi di grandi possibilità di diffusione su larga scala, possiamo aspettarci che il doppiaggio sarà presto diffuso a tutti i canali. Sarà la caduta dell’ultimo muro che divide le nazioni.

Vediamo i passaggi e a che punto siamo:

- Da audio a testo, riconoscendo chi sta parlando;

- Da testo in una lingua a testo in un’altra (censurando se necessario certi termini);

- Estrazione dall’audio delle le caratteristiche di una singola voce, per poterla riprodurre;

- Creazione di un audio nella nuova lingua, con la voce degli attori;

- Caricamento del nuovo audio;

- Modifica del video per adattare il labiale al nuovo testo.

Ciascuno di questi passaggi (tranne il quinto, banale) è una sfida a sé stante. E ciascuno di questi passaggi modificherà (o ha già modificato), il mondo una volta raggiunto. Nessuno di questi è irraggiungibile: sono tutti a portata di mano, alcuni già pronti.

Il rapporto tra doppiaggio, traduzione e intelligenza artificiale

Nell’analizzare il livello di un’intelligenza artificiale consideriamo che ciascuna IA (o AI in inglese) passa forzatamente attraverso questi passaggi:

- Non è in grado di fare una cosa;

- La può fare, ma è goffa, ridicola;

- La può fare malamente;

- La può fare come l’essere umano medio;

- La può fare come un esperto;

- La può fare meglio di qualsiasi singolo essere umano;

- La può fare meglio di tutti gli esseri umani messi insieme.

Ciascuna di queste tecnologie è da qualche parte su questa scala.

Iniziamo con la prima sfida, la trascrittura da audio a testo. Per l’audio parlato da una sola persona la tecnologia è a livello cinque, ovvero quello di un esperto. Se l’audio invece include più persone siamo a livello due o forse tre. Il software più avanzato in questo settore si chiama Whisper ed è stato pubblicato con codice open source da openAI (strano, direte voi). Molte persone hanno poi preso questo codice e sviluppato sotto-progetti, alcuni a pagamento, altri gratis. Se avete degli appunti da trascrivere sapete dove guardare.

La seconda sfida è quella della traduzione. E questo è un classico benchmark dell’intelligenza artificiale. Gia nel 2009 ho firmato un contratto di affitto tradotto dal portoghese in inglese con Google Translate. Allora era incredibile, adesso è una normale applicazione di una tecnologia conosciuta. Anche qui direi che il livello è tra il quarto e il quinto, a seconda della difficoltà del testo e di quanto il testo faccia riferimento a conoscenze particolari e a un determinato contesto.

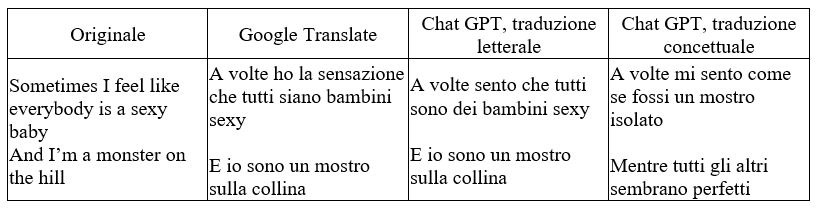

Per esempio, ecco una parte della canzone Anti-hero di Taylor Swift, tradotto in italiano sia da Google Translate (2023) che da ChatGpt 4 (versione 25 settembre 2023).

La seconda e la terza traduzione sono quasi identiche, sono traduzioni letterali. Poi però quando si chiede a chatGPT una traduzione concettuale diventa “A volte mi sento come se fossi un mostro isolato. Mentre tutti gli altri sembrano perfetti”. Rovescia la frase, usa costruzioni linguistiche specifiche (“sembrare perfetti” è una frase che si dice in italiano, come “sexy baby” in inglese, che non vuol certo dire “bambini sexy”). Il passaggio dal quarto al quinto livello non potrebbe essere più evidente.

Un altro problema che è stato risolto, cosa piuttosto spaventosa a pensarci, è la capacità dell’intelligenza artificiale di riprodurre la voce di una persona. Il sito famoso per fare questo è ElevenLabs. E qui siamo direttamente al livello sette, in quanto l’essere umano non è naturalmente in grado di farlo. Lo stesso con il passaggio sei, la modifica del labiale, che in fondo non è neanche così importante. L’Italia ha sempre avuto una fiorente industria di doppiatori, tra le migliori al mondo. Ma nessuno ha mai modificato i video per adattarli alle parole dei doppiatori. Al massimo i doppiatori adattavano leggermente il loro parlato, ma è raro. Ci sono stati doppiatori bravissimi, a volte migliori dell’originale. Non potete dirmi, per esempio, che il monologo de il Gladiatore “Mi chiamo Massimo Decimo Meridio, Comandante delle legioni del Nord,...” sia meglio in inglese con la voce originale di Russel Crowe (carina) che con quella di Luca Ward (i brividi).

Ecco, nel processo perderemo certamente qualcosa. Perché ogni passaggio sarà più fedele all’originale, ma smetterà di essere un passaggio creativo. In cambio però avremo la possibilità di “parlare con”, “imparare da” e “insegnare a” tutti. Già adesso su Facebook sotto i post c’è il tasto per la traduzione in automatico, e spesso i miei contenuti, in italiano, sono commentati dai miei amici inglesi. Questo fenomeno sarà sempre più diffuso.

Abbiamo visto che tutti i pezzi del puzzle sono ormai pronti, con l’unica eccezione della capacità di riconoscere chi sta parlando (se ne parla nei forum di Whisper e in molti ci stanno lavorando). Ma cosa succederà una volta che questa tecnologia verrà introdotta?

Intanto accadrà piano piano. Poche lingue alla volta, pochi creators alla volta.

Per evitare e correggere i possibili bugs intanto che colpiscono poche persone. Ma la lingua italiana non è una lingua secondaria. Forse per la lunghezza eccessiva delle parole, nella lista delle lingue in cui chatGPT funziona bene è al primo posto, sopra l’inglese! Quindi l’italiano diverrà presto disponibile.

Ma cosa succederà una volta che si apriranno i cancelli del doppiaggio in automatico? Sicuramente il settore dei doppiatori dovrà affrontare il problema, e si deve preparare già da ora. Non è una questione che potrà essere posposta, sperando che si eclissi a suon di cause milionarie. D’altra parte se si può inserire un audio tradotto nella voce dell’attore, allora si può introdurre qualsiasi voce in ogni video. Questo aprirà, e sta già aprendo, le porte alla vendita delle voci. È un po’ il business di ElevenLabs, che menzionavo prima. Io, nel caso, mi prenoto per dare al mio assistente personale AI la voce di Sakhile Dube, voi mettetevi pure in coda dietro di me.

Così le aziende di doppiaggio potrebbero diventare aziende che commercializzano voci. Questo apre un grosso dibattito sul copyright dei prodotti delle intelligenze artificiali, dibattito di cui spero parleremo un’altra volta.

Generalmente l’effetto sarà misto. Da una parte chiunque potrà vedere qualsiasi video, aprendo alla possibilità di seguire qualsiasi discussione. Quante persone rifiutano di esplorare un argomento perché non parlano inglese (o francese, tedesco, cinese, russo, arabo, swahili)? È un mondo che si apre. Mia figlia ama i documentari e io anche. Ma quelli che vedo io sono spesso più belli, e sempre più inglesi. Lei ha sei anni e non parla l’inglese. A volte mi chiede di tradurle la voce fuori campo e io, piano piano, lo faccio. Ma è faticoso per entrambi. In futuro si apriranno i cancelli e l’unica paura sarà che l’AI modifichi il labiale… delle balene.

D’altra parte, però, gli youtuber si troveranno a competere con i loro colleghi di tutto il mondo. Questo rischia veramente di distruggere la fauna locale. Se io voglio imparare il linguaggio di programmazione “python”, sceglierò il miglior youtuber in Italia, o al mondo? Esatto. I più bravi cresceranno ancora di più, ma molti youtuber italiani verranno schiacciati.

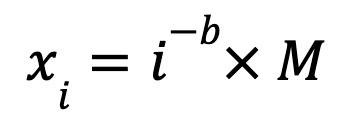

Questo si può anche prevedere matematicamente: la grandezza dei canali su YouTube segue una legge di potenza. Se mettiamo tutti gli youtuber in una lingua in ordine dal più popolare al meno popolare, possiamo calcolare quanti followers tende ad avere l’i-esimo. Supponiamo che il più popolare abbia 1 milione di followers (M=1.000.000), i followers dell’i-esimo youtuber saranno:

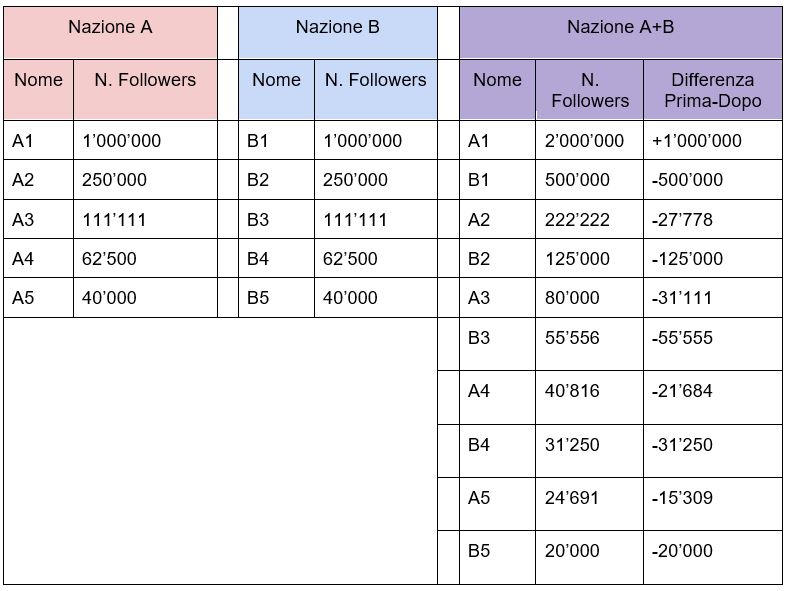

Con b che in genere ha un valore compreso tra 2 e 3. Dati questi presupposti se abbiamo 2 nazioni, ciascuna con 1000 youtuber, con il più grande youtuber che ha 1 milione di follower, lo youtuber medio ne avrà 1644, ma il mediano (quello che ha 499 youtuber più bravi e altrettanti meno bravi) ne avrà soltanto 4.

Se uniamo le due nazioni (perché adesso chiunque può seguire il canale di chiunque) avremo una nazione con 2000 youtuber, con un massimo numero di followers di 2 milioni, numero di followers medi sempre 1644, e numero di followers dello youtuber mediano 2.

Non sono però i più bravi ad aumentare il numero di followers, ma solo il primo: tutti gli altri perdono. Vediamo in una tabella cosa succede ai 5 youtuber più popolari per ciascuna nazione.

Insomma il risultato è che il più bravo aumenta i suoi followers, tutti gli altri ci perdono. Questo ovviamente è un modello molto astratto. In realtà le persone preferiranno (abbastanza) seguire i creators della loro cultura, quindi l’effetto sarà attutito. Inoltre, youtuber di argomenti diversi non sono in competizione diretta. Quindi aumenterà il numero di followers: il più bravo insegnate in Python e il più popolare gamer e il più popolare blog sul futuro e… Ma tutti gli altri perderanno followers.

Forse ci vorrebbero delle regole antitrust anche per gli youtuber, per mantenere la diversità. YouTube potrebbe cambiare l’algoritmo con cui pubblicizza i canali per attutire questo effetto. Ha infatti tutto da guadagnare nell’avere un’ecologia di youtubers per ogni argomento, piuttosto che uno singolo e bravo (e tutti gli altri molto meno seguiti). Ma ovviamente chi ci guadagna saremo noi, avendo una scelta più ampia. Se voi poteste seguire qualsiasi canale YouTube in qualsiasi lingua, chi seguireste che adesso vi è precluso?

Fonte dell'immagine di copertina: NordWood Themes/unsplash