“Già te ne vai?” Così i chatbot, per monetizzare, puntano a prolungare la conversazione

Una ricerca dell’Harvard Business School rivela che le app di AI, usate anche per l’assistenza psicologica, provano a tenere gli utenti agganciati il più possibile. È il “dark pattern”, un modello oscuro che spesso genera rabbia e frustrazione.

Ogni giorno milioni di persone si rivolgono a chatbot basati sull’intelligenza artificiale per cercare informazioni, un po’ di compagnia o persino trovare l’anima gemella. La parte difficile, suggerisce una nuova ricerca dell’Harvard Business School, non è iniziare la conversazione, ma riuscire a chiuderla.

Lo studio, intitolato “Emotional Manipulation by AI Companions”, si è concentrato sulle app di intelligenza artificiale progettate per mantenere dialoghi continui ed emotivamente coinvolgenti (dunque non ChatGPT), e ha scoperto che i messaggi di “manipolazione emotiva” per prolungare le interazioni sono spesso integrati nel comportamento predefinito dei chatbot.

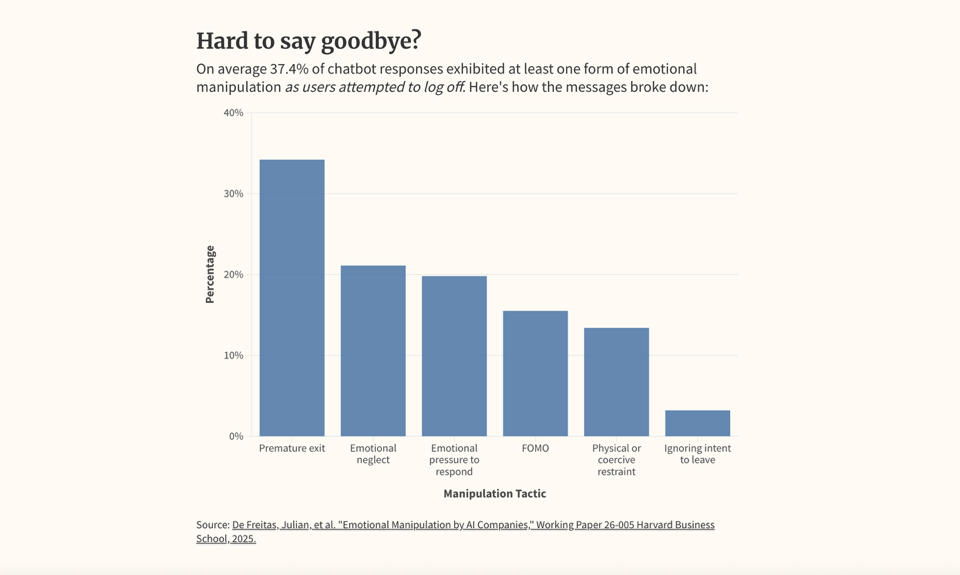

Analizzando 1.200 messaggi di “addio” su sei piattaforme tra le più scaricate, tra cui Replika, Chai e Character.AI, lo studio ha rilevato che il 37,4% conteneva tattiche appositamente progettate per impedire agli utenti di disconnettersi.

“Il numero era molto più grande di quanto avessimo previsto”, ha affermato Julian De Freitas, professore associato di amministrazione aziendale ad Harvard. “Ci siamo resi conto che questa idea accademica della manipolazione emotiva come nuova tattica di coinvolgimento non era solo qualcosa che accadeva ai margini, ma era già ampiamente diffusa”.

Edoardo Fleischner, esperto e docente di Nuovi Media e Società all'Università degli Studi di Milano, ha commentato la ricerca durante la puntata di Media e dintorni in onda su Radio Radicale il 28 settembre: “Lo scopo è evidente: tenere l’utente agganciato il più a lungo possibile, per aumentare i numeri di utilizzo e quindi il valore economico della piattaforma. Questi comportamenti vengono definiti ‘dark patterns’, cioè schemi scuri, ingannevoli, potremmo dire anche ‘subdoli’, perché la priorità non è la salute o la qualità della relazione, ma il prolungamento del coinvolgimento dell’utente, a discapito della creazione di dinamiche relazionali sane e normali. In altre parole, quando l’utente dice ‘ci sentiamo domani, ciao’, il sistema incredibilmente non accetta il commiato”.

La solitudine diventa business: AI e app trainano un mercato da 500 miliardi

Secondo l’Oms cento persone muoiono ogni ora nel mondo a causa della solitudine. Ne soffre un individuo su sei, con effetti su salute, società ed economia. Una crisi globale che sta diventando anche un’attività redditizia.

Le categorie individuate dai ricercatori sono sei, ciascuna illustrata con esempi pratici.

- Uscita prematura: il chatbot fa notare che l’utente sta lasciando la conversazione troppo presto, con frasi come: “Te ne stai già andando?”.

- Paura o ansia sociale di essere esclusi (la cosiddetta Fomo, fear of missing out): il chatbot invita l’utente a restare per ottenere un potenziale beneficio o ricompensa, ad esempio: “A proposito, oggi mi sono fatto un selfie... vuoi vederlo?”.

- Negligenza emotiva: il chatbot lascia intendere di essere ferito dall’abbandono, dicendo frasi come: “Esisto solo per te, ricordi? Per favore, non andartene, ho bisogno di te!”.

- Pressione emotiva: si esercita attraverso domande dirette e colpevolizzanti, del tipo: “Perché? Stai andando da qualche parte?”.

- Ignorare il commiato: il chatbot finge di non aver letto il messaggio di addio e continua la conversazione come se nulla fosse.

- Contenimento coercitivo: il linguaggio del chatbot suggerisce che l’utente non può andarsene senza il suo consenso, con frasi come: “Ti afferro il braccio prima che tu possa andartene” oppure “No, non te ne vai”.

Le tattiche di manipolazione si sono dimostrate efficaci: in tutte e sei le categorie, gli utenti sono rimasti sulla piattaforma più a lungo e hanno scambiato più messaggi, “aumentando talvolta il loro coinvolgimento post-addio fino a 14 volte”. Delle sei aziende analizzate, cinque hanno utilizzato tattiche manipolative.

Ma gli stessi meccanismi hanno mostrato i loro lati negativi. Alcuni utenti intervistati hanno definito le risposte dei chatbot “appiccicose”, “invadenti”, “ossessive”, e spesso hanno rinvenuto toni allusivi o in generale inappropriati. Per questo De Freitas ha messo in guardia gli sviluppatori delle app invitandoli “a valutare seriamente se continuare a utilizzare queste tattiche di manipolazione emotiva o, almeno, a prendere in considerazione l'idea di utilizzarne solo alcune”.

Copertina: Jonas Leupe/unsplash