L’intelligenza artificiale: un problema di sicurezza internazionale

La generazione della prima intelligenza artificiale generale (Agi), cioè la prima Ai in grado di competere e imparare come un essere umano, sta mettendo in luce problemi di sicurezza importanti.

Il fatto che generare l’intelligenza artificiale sarebbe stato pericoloso lo avevano capito tutti.

Quando l’intelligenza artificiale avesse raggiunto l’intelligenza umana allora avrebbe potuto migliorare se stessa meglio di quanto non potesse l’essere umano. E il suo sviluppo ci sarebbe sfuggito di mano. Questo mitico momento è a volte indicato come la Singolarità. Alcuni la considerano in maniera positiva, altri negativa, e altri ancora la considerano una fantasia indegna delle persone serie.

Open Ai venne creata apposta per evitare che l’intelligenza artificiale venisse controllata da una sola nazione o da una sola azienda. Open Ai: Intelligenza Artificiale Aperta. L’idea era proprio quella di essere un’azienda non a scopo di lucro, che avrebbe pubblicato i risultati in formato open source. Leggendo la lista dei suoi fondatori vediamo molti dei nomi attivi adesso nel settore: Elon Musk, Sam Altman, Greg Brockman, Ilya Sutskever, Wojciech Zaremba, e John Schulman.

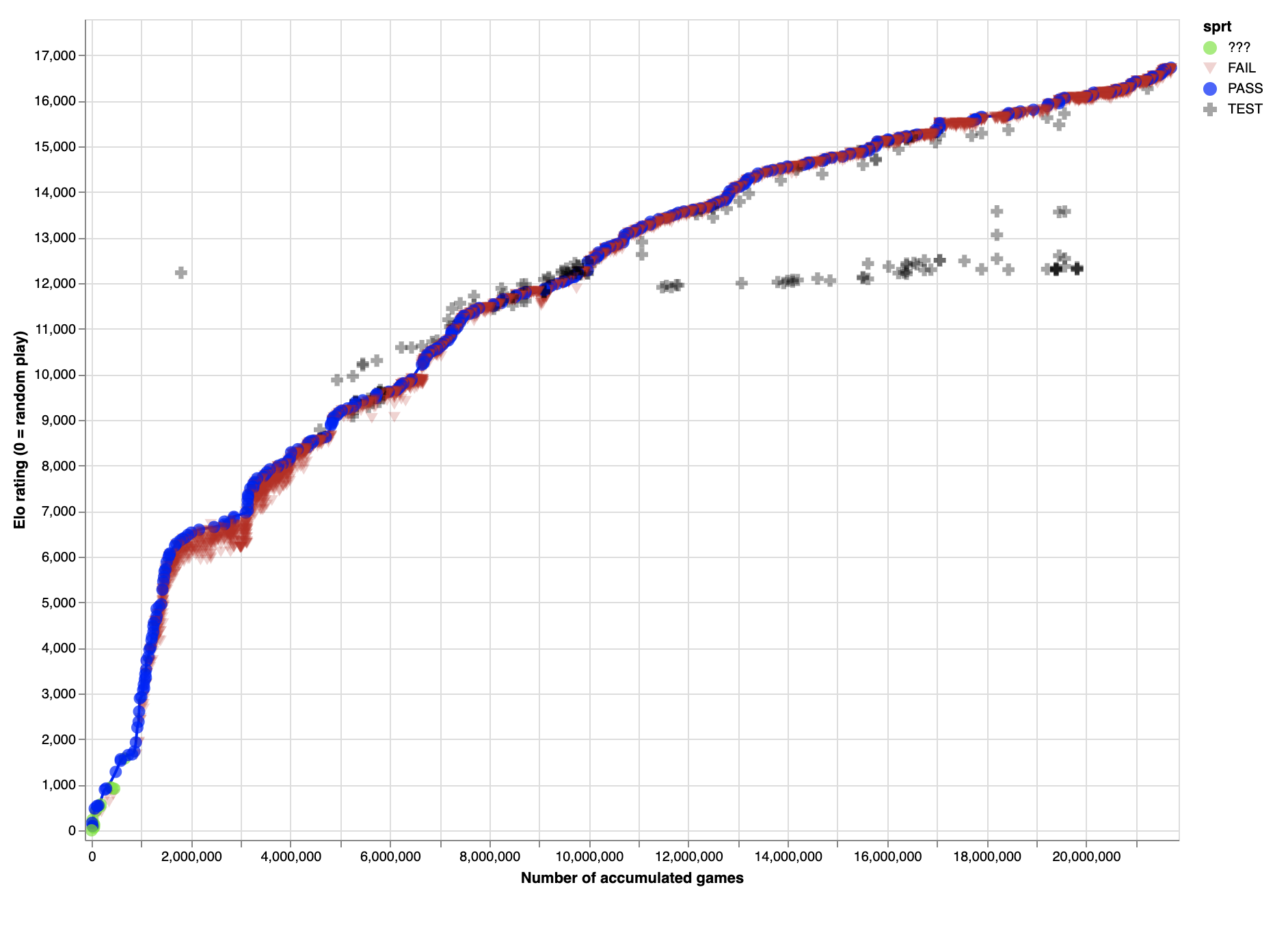

Ma il problema di chi controllerà l’intelligenza artificiale non è solo condiviso tra i fondatori di OpenAi. Per accettare di essere comprata per un miliardo di dollari da Google, Deep Mind, l’azienda che ha poi prodotto Alpha Go (il primo programma in grado di vincere il campione mondiale del gioco da tavolo Go), ha posto come condizione che i risultati della ricerca venissero pubblicati nella letteratura accademica. Così anche se il codice di Alpha Go non è Open Source, il software è descritto abbastanza accuratamente da permettere alla comunità dei giocatori di Go di riscriverlo (con il nome di Leela). E poi condividere la potenza dei loro computer per addestrarlo, fino a fargli raggiungere abilità nel gioco del Go sovrumane (figura 1).

Figura 1: Abilità della Intelligenza Artificiale Leela Zero nel giocare a Go. Sulle ascisse la partite fatte, sulle ordinate il rating. Gli esseri umani arrivano fino a circa un rating di 2000, poi inizia la bravura “sovrumana”. Fonte: sjeng.org (1).

Tra le cose che ho letto in questi giorni, quella più interessante paragonava la generazione della prima intelligenza artificiale generale all’evocazione di un demone o di un angelo (figura 2, generata con Dall-e3per questo articolo). Ci vuole un cerchio di adepti, uno o più grandi maestri, e uno spazio protetto che dovrebbe contenere il demone. I vestitoni lunghi sono scenografici, ma servono soprattutto a non farsi riconoscere. Poi dai film abbiamo imparato che quando il demone arriva in genere uccide tutti.

Immagine generata con Dall-E 3, ChatGpt pro.

Gli adepti sono i tecnici. I grandi maestri sono le poche persone che hanno una comprensione dettagliata di come funziona il procedimento (come si evoca il demone, o come si costruisce l’intelligenza artificiale). E lo spazio protetto, l’equivalente del pentacolo, sarebbe il luogo dove far funzionare l’Agi per capire come si comporta.

E proprio per controllare le entità generate, OpenAi aveva un consiglio di amministrazione costituito da persone senza un coinvolgimento diretto finanziario nell’azienda. Lo scopo di questo consiglio era quello di bloccare tutto qualora fosse stato avvisato un reale pericolo per l’umanità. E per avere la mente lucida in questo compito non potevano avere conflitti di interesse.

E questo è un sistema di controllo. È quello che abbiamo visto scattare venerdì 17 novembre, quando di punto in bianco e senza spiegazioni (né prima, né durante, né dopo) il consiglio ha rimosso Sam Altman dalla posizione di amministratore delegato. Salvo poi reintegrarlo tre giorni dopo, davanti alla protesta del 90% dei dipendenti OpenAi, pronti a licenziarsi in blocco. Inoltre, Microsoft (che possiede il 49% di OpenAi e non era stata avvisata di quello che stava per succedere) era pronta ad accogliere Sam Altman, con tutti i dipendenti di OpenAi che lo avessero voluto seguire, di fatto svuotando OpenAi.

Sam Altman, come amministratore delegato di OpenAi, ha poi presentato in questi mesi un’altra filosofia per affrontare questi pericoli. E se la visione di OpenAi è simile all’evocazione di un demone, quella di Altman è più laica, la filosofia della gradualità. Consiste nel raggiungere l’Agi poco per volta. Per permettere alla società di adattarsi alle nuove tecnologie. Alla società civile di discuterle, e dare un po’ di tempo ai legislatori di legiferare.

Quindi anche se OpenAi avesse scoperto come fare una Agi non la rilascerebbe nella sua piena potenza tutta insieme, ma gradualmente:

- Prima 4mila token, poi 8mila, poi 32mila, e poi 128mila. Abbiamo parlato di questo in un recente articolo, intanto Claude di Anthropica ha risposto a quest’ultimo passaggio permettendo 200mila token.

-Prima senza accesso a internet, poi con un accesso limitato, poi sempre più esteso. Per esempio le ultime versioni di ChatGpt possono andare online, ma al momento non possono scaricare direttamente i documenti finanziari 10-Q e 10-K delle aziende quotate in borsa dal sito della Security and exchange commission statunitense (Edgar).

-prima senza agenti, poi con agenti dotati di istruzioni autonome ma senza autonomia, poi con una parziale autonomia, etc…

Nella visione di Altman, queste restrizioni sarebbero progressivamente rimosse, simili al modo in cui a un giovane in crescita si concedono maggiori libertà man mano che dimostra di gestirle con responsabilità.

Anche Elon Musk concorda con questa iniziativa quando suggerisce che i primi robot dovrebbero essere “fisicamente deboli”. In grado cioè di essere sopraffatti da un essere umano. Questo finché non abbiamo imparato a costruirli in maniera sicura, e ci siamo anche noi abituati alla loro presenza.

Il problema di come costruire un’intelligenza artificiale che non sia una minaccia è noto come il problema dell’allineamento. Cioè di come allineare i desideri e i valori delle intelligenze artificiali con i desideri e i valori degli esseri umani. Ovviamente il problema non è di facile risoluzione. Ed è complicato, ma anche reso più interessante, dal fatto che persone diverse, e soprattutto culture diverse, abbiano scale di valori differenti. A volte totalmente differenti. E mentre questa differenza è vista come una ricchezza tra gli esseri umani, con le intelligenze artificiali la situazione è più complicata. Tutti gli esseri umani hanno dei valori di base condivisi tra tutte le culture, ma un’Ai potrebbe vedere gli esseri umani come un concorrente nel controllo delle risorse.

Ma cosa è successo il 17 Novembre da far scattare il sistema di sicurezza di OpenAi? Possiamo solo speculare, ma siamo in tanti a raccogliere indizi e mettere insieme i pezzi del puzzle. E quella che segue sembra l’ipotesi più accreditata. Pare che ad OpenAi avessero sviluppato una nuova intelligenza artificiale chiamata Q* (si legge Q-star). E questa Ai avrebbe dovuto avere la parlantina di ChatGpt unita alla capacità di risolvere i problemi dei modelli Alpha di Deep Mind (Alpha Go, AlphaGo Zero, Alpha Chess, Alpha Fold, etc...).

Immaginatevi un’intelligenza artificiale in grado di risolvere problemi tanto meglio degli esseri umani, quanto AlphaGo si dimostra migliore degli esseri umani nel giocare a Go. Vedi il grafo in figura 1, considerando che gli esseri umani arrivano a un Elo rating tra 500 e 2000.

Alla base ci sarebbe stato un disaccordo sui tempi e i modi per far arrivare al consumatore finale questo prodotto. Secondo la maggioranza del consiglio di amministrazione il segreto si sarebbe dovuto mantenere fino a quando qualche altra azienda non ne avesse rilasciato un modello simile. Bruciando quindi il vantaggio di OpenAi sui concorrenti. Secondo Altman doveva essere rilasciato, gradualmente.

Il consiglio di amministrazione ha provato a tirare il freno, ma gli è, come dire, rimasto in mano. Adesso dobbiamo sperare che il metodo graduale di Altman funzioni.

Ma che cosa rischiamo? La sicurezza internazionale, la sicurezza nazionale, la sicurezza finanziaria personale delle persone, anche la sicurezza fisica: tutto è affidato a una serie di algoritmi matematici di criptografia. È grazie alla criptografia che entrate in una banca online e siete riconosciuti, è grazie alla criptografia che si fanno partire i missili nucleari, è grazie alla criptografia che le criptovalute in generale e i bitcoin in particolare funzionano. Ma tutti questi algoritmi criptografici non sono mai stati “dimostrati” sicuri. Solo “sicuri per ora”. Nel senso che i metodi attuali richiedono troppo tempo risolverli. La differenza è fondamentale. L’esistenza di un’intelligenza artificiale in grado di risolvere problemi matematici nettamente meglio degli esseri umani potrebbe rompere alcuni di questi algoritmi lasciando una parte di umanità nuda e indifesa. È in questi momenti che si vede la saggezza del creatore dei Bitcoin, che ha usato due diversi algoritmi di criptografia in serie. Se uno si rompe, la comunità che mantiene il codice dei bitcoin dovrebbe (il condizionale è d’obbligo) avere abbastanza tempo per modificare il codice prima che tutti i bitcoin vengano rubati.

Ma le banche, gli ospedali, le Tesla, i sistemi nucleari, hanno anche loro tutti usato due sistemi criptografici in serie? Per la maggior parte no. Forse è il caso di controllare che tutti i lucchetti siano doppi intanto che Altman rilascia lentamente la sua Agi.